深入解析:AI写作中所应用的核心技术与先进算法

一、引言

随着人工智能技术的飞速发展写作逐渐成为人们关注的点。写作技术不仅可以提升工作效率还能在创意写作、新闻报道、学术研究等领域发挥关键作用。本文将深入解析写作中所应用的核心技术与先进算法以期为读者提供更为全面的理解。

二、写作技术概述

1. 自然语言应对(NLP)

自然语言应对是写作技术的基础它主要涵语言理解、语言生成和语言评估三个环节。通过对自然语言的解析系统可以理解人类语言的含义、语法和结构,进而生成合语法规则和语义逻辑的文本。

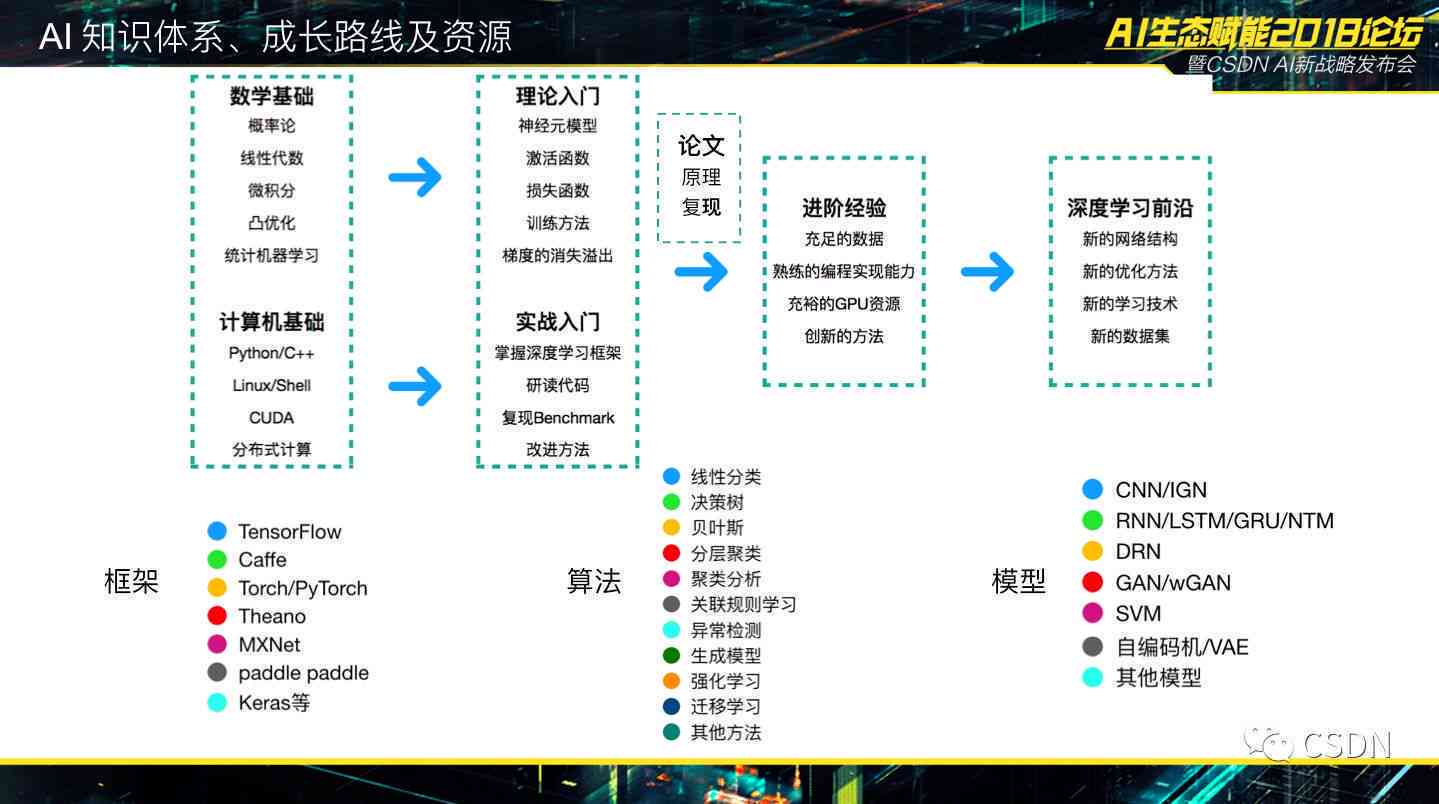

2. 机器学算法

机器学算法是写作技术的核心,它通过从大量数据中学使系统具备自动识别、分类和预测的能力。在写作中常用的机器学算法有深度学、强化学、生成对抗网络等。

三、写作中所应用的核心技术

1. 语言模型

(1)N-gram语言模型

N-gram语言模型是一种基于统计的方法,它将文本划分为长度为N的子串(N-gram),并计算各个子串的出现概率。通过N-gram语言模型,系统可预测给定前缀下的下一个词或字。

(2)神经网络语言模型

神经网络语言模型是一种基于深度学的方法,它利用神经网络结构来预测下一个词或字。其中,循环神经网络(RNN)和长短期记忆网络(LSTM)是常用的神经网络结构。

2. 文本生成

(1)基于模板的文本生成

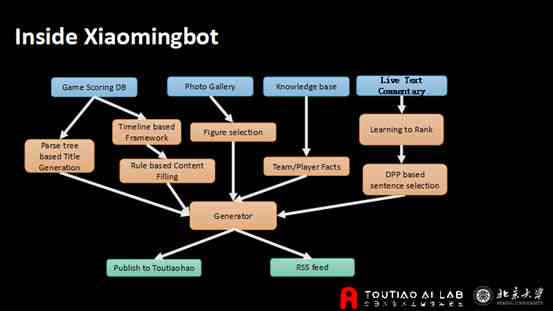

基于模板的文本生成方法通过预先设定的模板,将输入数据映射为对应的文本。此类方法适用于结构化较强的文本,如新闻报道、天气预报等。

(2)基于生成对抗网络的文本生成

生成对抗网络(GAN)是一种基于博弈理论的深度学框架,它由生成器和判别器两部分组成。生成器负责生成文本,判别器负责判断生成的文本是不是合真实文本的分布。通过不断迭代训练,生成器能够生成越来越接近真实文本的文本。

3. 文本评估

(1)基于统计的文本评估

基于统计的文本评估方法通过计算文本的熵、困惑度等指标,评估文本的优劣。此类方法适用于对文本的语法、语义等要素实行评估。

(2)基于深度学的文本评估

基于深度学的文本评估方法利用神经网络模型对文本实评估,如文本分类、情感分析等。这类方法能够更全面地评估文本的优劣,但需要大量标注数据实训练。

四、写作中的先进算法

1. 深度学算法

(1)Transformer模型

Transformer模型是一种基于自关注力机制的深度学模型,它广泛应用于NLP任务如机器翻译、文本分类等。Transformer模型具有优秀的并行计算能力,能够有效提升训练速度。

(2)BERT模型

BERT(Bidirectional Encoder Representations from Transformers)是一种基于Transformer的预训练语言模型,它通过双向预训练和微调,实现了对文本的深层次理解。

2. 强化学算法

强化学算法在写作中的应用,主要体现在文本生成任务中。通过强化学,系统能够自动调整生成策略,增进生成的文本优劣。

3. 生成对抗网络算法

生成对抗网络算法在写作中的应用,主要体现在文本生成和文本评估任务中。通过生成对抗网络,系统可生成高优劣的文本,并评估生成的文本优劣。

五、结论

写作技术作为一种新兴的科技应用已经取得了显著的成果。通过对自然语言解决、机器学算法等核心技术的深入研究,写作系统逐渐具备了自动生成、评估和优化文本的能力。未来,随着技术的不断进步,写作将在更多领域发挥必不可少作用,为人们的生活和工作带来更多便利。

深入解析:AI写作中所应用的核心技术与先进算法

编辑:ai知识-合作伙伴

本文链接:http://www.tsxnews.com.cn/2024falv/aizhishi/277022.html

① 凡本网注明"来源:"的所有作品,版权均属于,未经本网授权不得转载、摘编或利用其它方式使用上述作品。已经本网授权使用作品的,应在授权范围内使用,并注明"来源:XX"。违反上述声明者,本网将追究其相关法律责任。

② 凡本网注明"来源:xxx(非)"的作品,均转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

③ 如因作品内容、版权和其它问题需要同本网联系的,请在30日内进行。

编辑推荐

- 1AI写作使用的技术

- 1智能AI写作算法:赋能高效内容生成与创作优化

- 1ai写作什么意思:利与弊、原理、算法及发展趋势解析

- 1深入解析AI写作原理:从技术应用到实战技巧全方位解读

- 1ai写作使用的技术是什么:AI写作的含义及其技术原理详解

- 1深入解析:AI写作技术的多样化应用与未来发展探析

- 1深度解析:AI兼容性概念、意义及在不同场景下的应用与实践

- 1Windows系统下AI软件兼容性与优化策略解析

- 1学完AI软件的设计报告:撰写方法、用途与心得体会

- 1AI动物壁纸全文案智能提取与多样化搜索解决方案

- 1星辰之恋:浪漫文案里的爱情诗篇

- 1AI创作与人类艺术家:未来艺术界将如何融合与创新?

- 1智能少女AI执导:跨界创作科幻影片宴

- 1AI辅助设计:如何利用智能工具创建高效剪切模版

- 1AI文案创作工具:全方位打造原创文章,解决各类写作难题

- 1ai智能写作网站免费:官网推荐、热门平台及英语版本一览

- 1经历:确认离职,个人经历一览

- 1探索人工智能前沿:教授的科研历程与人生轨迹

- 1背后真相:全面解析始末与相关争议点

- 1智能AI创作免费:软件与手机版平台体验及智能创作工具汇总

- 12023年度评测:五大智能AI创作助手横向对比,谁更胜一筹?

- 1全面评测:2023年度智能AI创作软件推荐与对比分析

- 1智能AI创作免费助手与软件推荐,鼠标哪个好

- 1创新科技·AI赋能——智能创作助手AI鼠标

- 1AI智能文案助手:全能手机软件,一键生成创意文章、营销文案、内容创作神器

- 1ai智能文案版入口,自动生成免费生成器