ai测评一般都问些什么:常见问题及内容解析

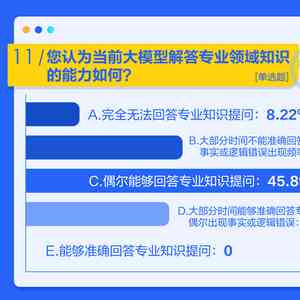

在当今科技飞速发展的时代人工智能()已经成为各行业关注的点。为了评估的性能、准确性和适用性测评成为了不可或缺的环节。多人在面对测评时也会对测评进展中可能遇到的疑惑感到困惑。本文将为您解析测评中常见的疑问帮助您更好地理解测评的内容及意义。

一、测评一般都问些什么:常见疑惑及内容解析

测评作为评估系统性能的必不可少手,涉及多方面的疑惑。以下咱们将探讨测评中常见的疑问,并对其实详细解析。

二、测评一般都问些什么疑问

测评进展中,往往会问到以下几类疑问:

1. 实小编的性能指标

在测评中,首先会关注模型的性能指标,如准确率、召回率、F1值等。这些疑惑旨在熟悉模型在特定任务上的表现以及与人类专家的差距。

准确率(Accuracy)是模型正确预测样本的比例,反映了模型的总体性能。召回率(Recall)是模型正确识别正样本的比例反映了模型对正样本的识别能力。F1值是准确率和召回率的调和平均值,综合反映了模型的性能。

2. 实小编在不同数据集上的表现

为了全面评估实小编的性能,测评人员会关注模型在不同数据集上的表现。这包含数据集的多样性、规模、分布等。

在不同数据集上测试实小编,可以检验模型的泛化能力。泛化能力强的模型,可以在多种场景下表现良好。通过对比模型在不同数据集上的表现,可发现模型的局限性,为后续优化提供方向。

3. 实小编的可解释性

随着在各个领域的应用越来越广泛模型的可解释性越来越受到关注。测评人员会问到关于模型决策过程、关键特征等方面的疑问。

可解释性强的实小编能够让人更容易理解模型的决策过程,从而提升模型的可靠性和信任度。目前已有多方法用于提升实小编的可解释性,如留意力机制、特征关键性分析等。

4. 实小编的安全性

实小编在应用进展中,可能存在面临各种安全风险。测评人员会关注模型对对抗样本、隐私泄露等风险的抵抗力。

为了确信实小编的安全性,研究人员需要对模型实行安全性评估,包含对抗样本攻击、数据泄露等。通过这些评估,能够发现模型的潜在风险并采纳相应措加以防范。

三、测评一般都问些什么内容

测评的内容主要包含以下几个方面:

1. 数据准备与预解决

数据是实小编训练的基础,测评人员会关注数据的品质、规模、分布等方面。数据准备与预解决包含数据清洗、数据增强、数据标注等。

数据准备与预应对是测评的关键环节,直接作用模型的性能。高品质的数据,能够加强模型的训练效果和泛化能力。数据增强、数据标注等方法,能够加强数据的多样性,有助于模型学到更多的特征。

2. 模型选择与优化

在测评中,模型选择与优化是关键环节。测评人员会关注模型的类型、结构、参数等方面。

模型选择与优化需要依据任务需求、数据特点等因素实行。不同类型的模型具有不同的特点,如深度学模型擅长应对图像、语音等复杂数据而传统机器学模型在应对小样本数据方面具有优势。通过优化模型结构、参数,能够提升模型的性能。

3. 模型评估与验证

模型评估与验证是测评的核心环节。测评人员会关注模型的性能指标、稳定性、可解释性等方面。

模型评估与验证需要采用多种方法,如交叉验证、留一法等。这些方法可检验模型的泛化能力、稳定性等。同时评估指标的选择也很要紧,需要依据任务需求、数据特点等因素实选择。

4. 结果分析与报告

测评的最目的是为了改进模型和应用。 结果分析与报告是测评期间不可或缺的环节。

结果分析与报告需要详细描述模型的性能、局限性、改进方向等。这有助于研究人员理解模型的优缺点,为后续优化和应用提供依据。

四、测评是什么意思

测评,即人工智能测评,是对系统性能、准确性和适用性实评估的过程。通过测评,可理解系统的优点和局限性为优化模型和应用提供参考。

测评包含多个方面,如模型性能、数据优劣、模型选择与优化、结果分析与报告等。每个环节都对系统的性能和适用性产生要紧作用。通过全面、深入的测评,可确信系统在实际应用中发挥出效果。

测评是评估系统性能的关键手。理解测评中常见的疑惑和内容,有助于咱们更好地评估和优化系统。在未来的发展中,测评将继续发挥着必不可少作用,推动人工智能技术的进步。

ai测评一般都问些什么:常见问题及内容解析

编辑:ai学习-合作伙伴

本文链接:http://www.tsxnews.com.cn/2024falv/aixuexi/366487.html

上一篇:全方位AI工具测评:深度解析智能搜索与创作助手,解锁高效信息获取新境界

下一篇:深入解析AI测评:含义、方法、应用与常见问题全解读

① 凡本网注明"来源:"的所有作品,版权均属于,未经本网授权不得转载、摘编或利用其它方式使用上述作品。已经本网授权使用作品的,应在授权范围内使用,并注明"来源:XX"。违反上述声明者,本网将追究其相关法律责任。

② 凡本网注明"来源:xxx(非)"的作品,均转载自其它媒体,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

③ 如因作品内容、版权和其它问题需要同本网联系的,请在30日内进行。

编辑推荐

- 1人工智能性能评估试题集锦:全面测试AI技术实力

- 1全方位AI工具测评:深度解析智能搜索与创作助手,解锁高效信息获取新境界

- 1人工智能全面评测:AI全程测评文案撰写攻略与实践指南

- 1AI创作的作品是否属于知识产权保护及其产品范围-ai创作的作品著作权归谁

- 1探讨AI创作版权归属:人工智能作品的知识产权解析与法律挑战

- 1AI创作内容:版权归属与界定解析

- 1ai创作内容版权多少钱,单次与月度版权费用解析

- 1nnai写作的运用范围包括什么:多样化场景与内容概述

- 1AI写作技术在多领域应用探究:涵哪些关键领域与场景

- 1AI文案创作全攻略:探索模板使用与自定义创作技巧,解决所有相关问题

- 1用AI写文案有模板吗怎么弄:如何制作并使用模板简化创作流程

- 1智能AI驱动的高效文案创作助手

- 1AI智能文案生成:一键解决多样化写作需求,涵创意、营销、报告各类场景

- 1用AI打造小红书爆款文案怎么写:撰写与技巧吸引人攻略

- 1'运用AI技术,创造小红书内容营销新高峰:打造爆款文案秘'

- 1AI赋能小红书:从爆款标题到完美内容,一键打造全文攻略

- 1小红书文案制作:全方位教程、工具与流程攻略